| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Timeout

- EKS

- 묘공단

- 컨테이너

- go

- kubernetes

- 쿠버네티스

- windows

- upgrade

- kcsa

- Kind

- AutoScaling

- node pool

- aws

- Azure

- ca

- WSL

- HPA

- ubuntu

- AKS

- curl

- Karpenter

- node group

- virtual nodes

- vscode

- calico

- 업그레이드

- KEDA

- ansible

- VPA

- Today

- Total

목록EKS (11)

a story

[8] EKS Upgrade

[8] EKS Upgrade

이번 포스트에서는 EKS Upgrade를 실습을 통해서 알아보겠습니다. 본 실습은 EKS Workshop인 Amazon EKS Upgrades: Strategies and Best Practices 를 바탕으로 진행하였음을 알려드립니다.해당 워크샵 링크는 아래와 같습니다.https://catalog.us-east-1.prod.workshops.aws/workshops/693bdee4-bc31-41d5-841f-54e3e54f8f4a/en-US 목차EKS의 업그레이드와 전략실습 환경 개요In-place 클러스터 업그레이드3.1. 컨트롤 플레인 업그레이드 3.2. Addons 업그레이드3.3. 관리형 노드 그룹 업그레이드 3.4. Karpenter 노드 업그레이드3.5. Self-managed 노드 업그레이..

[7] EKS Fargate

[7] EKS Fargate

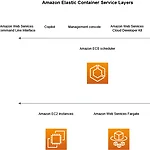

이번 포스트에서는 EKS의 Fargate에 대해서 살펴보겠습니다. EKS Fargate는 EKS의 노드 그룹을 사용하지 않고 컨테이너를 서버리스 컴퓨팅 엔진에 실행하는 방식입니다.먼저 EKS Fargate를 살펴보고, 이와 유사한 AKS의 Virtual Nodes를 통해 각 Managed Kubernetes Service에서 노드를 사용하지 않고 컨테이너를 실행하기 위한 구현 방식을 살펴보고, 실습을 통해 확인해보습니다. 목차EKS의 FargateAKS의 Virtual Nodes 1. EKS Fargate일반적으로 EKS에서는 노드 그룹을 생성하여 워커 노드를 사용할 수 있습니다. EKS의 컴퓨팅을 제공하는 옵션 중 노드인 EC2 인스턴스를 활용하지 않는 방식으로 EKS Fargate가 있습니다. 먼저 ..

[6] EKS의 Security - EKS 인증/인가와 Pod IAM 권한 할당

[6] EKS의 Security - EKS 인증/인가와 Pod IAM 권한 할당

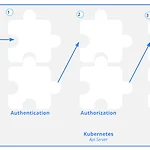

이번 포스트에서는 EKS의 보안(Security)에 대해서 알아 보겠습니다. 물론 쿠버네티스의 보안에는 이미지 보안, 노드 보안과 같은 영역도 있지만, 여기서는 쿠버네티스의 인증(Authentication)/인가(Authorization)가 EKS에 적용된 방식과, 워크로드(파드)의 AWS의 리소스에 대한 보안 접근이라는 두 가지 주제를 살펴보겠습니다. 먼저 EKS의 인증/인가의 흐름을 kubeconfig를 바탕으로 이해해보고, 두번째로 워크로드(파드)에 AWS의 리소스에 접근 권한을 부여하기 위해 파드에 IAM을 할당하는 방식에 대해서 살펴보겠습니다. 목차Kubernetes의 인증/인가EKS의 인증/인가AKS의 인증/인가Kubernetes의 파드 권한EKS의 파드 권한 할당AKS의 파드 권한 할당 1...

[5-2] EKS의 오토스케일링 Part2

[5-2] EKS의 오토스케일링 Part2

본 포스트에서는 기본적인 쿠버네티스 환경의 스케일링 기술을 살펴보겠습니다. 이후 EKS의 오토스케일링 옵션을 살펴보고, 각 옵션을 실습을 통해 살펴도록 하겠습니다. 마지막으로 AKS의 오토스케일링 옵션을 EKS와 비교해 보겠습니다. 이번 포스트에서는 EKS의 오토스케일링(Autoscaling) Part2로 지난 포스트에 이어서 Cluster Autoscaler 부터 이어나가겠습니다. 목차EKS의 오토스케일링 Part1 (https://a-person.tistory.com/38)쿠버네티스 환경의 스케일링EKS의 오토스케일링 개요실습 환경 생성HPA(Horizontal Pod Autoscaler)KEDA(Kubernetes Event-driven Autoscaler)VPA(Vertical Pod Autosc..

[5-1] EKS의 오토스케일링 Part1

[5-1] EKS의 오토스케일링 Part1

이번 포스트에서는 EKS의 오토스케일링(Autoscaling) 옵션을 살펴보겠습니다. 기본적인 쿠버네티스 환경의 스케일링 옵션을 전반적으로 살펴보겠습니다. 이후 EKS의 오토스케일링 옵션을 살펴보고, 이를 실습을 통해 확인 해보도록 하겠습니다. 마지막으로 AKS의 오토스케일링 옵션을 EKS와 비교해 보겠습니다. 글을 작성하는 과정에서 분량이 너무 길어져, Part1에서는 HPA, KEDA, VPA까지의 내용을 다루고 Part2에서 Cluster Autoscaler 부터 이어서 설명하도록 하겠습니다. 목차EKS의 오토스케일링 Part1쿠버네티스 환경의 스케일링EKS의 오토스케일링 개요실습 환경 생성HPA(Horizontal Pod Autoscaler)KEDA(Kubernetes Event-driven Au..